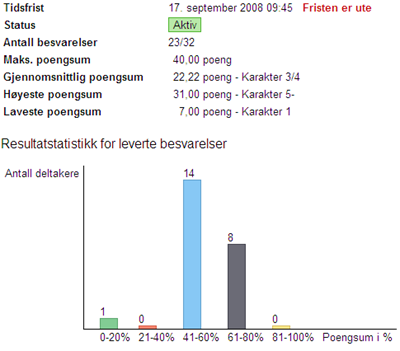

Her er statistikken over den første prøven jeg har gjennomført ved hjelp av testverktøyene i It's Learning i år:

Prøven er lagd etter beste evne og ut fra tips på bloggene til både Leif, Frøydis og Svend Andreas. Egentlig er det 30 elever fordi jeg har to ikke-norskspråklige elever som ikke deltar på slike tester. 6 stykker var syke - det er ikke lite sykdom i en så frisk del av befolkningen. En leverte ufullstendig besvarelse, og da gjenstår det 23 besvarelser. Gjennomsnittskarakteren er 3/4. Oppgavene var stort sett flervalg, men det var også 7 åpne oppgaver. Dette stresset elevene kraftig, og disse oppgavene skilte også godt mellom de som hadde lest og de som ikke hadde det. Vi ga dem totalt 40 spørsmål, og de oppfattet prøven som veldig vanskelig.

Jeg er ikke fornøyd med dette resultatet. Vi har brukt veldig mye tid på en nokså liten del av fagstoffet, og det burde være mulig å lære seg noen navn, sammenhenger og årstall slik at resultatene blir bedre enn dette. Prøven kan selvsagt ha vært veldig vanskelig. Bruk av nøkkelord fungerer tilsynelatende veldig tilfeldig i disse testene, og jeg vil ikke satse på automatisk retting av slike prøver. Derfor er alle disse gjennomgått manuelt, noe som ga bedre resultater for flere av elevene. Jeg er usikker på om dette gir et riktig bilde av elevenes kunnskaper. De fremstår som bedre orientert, mange av dem, og jeg lurer på om spørsmålene er gode nok. Hvordan lager dere andre tester i It's Learning for å eliminere feiltolkninger etc? Og hvordan få elevene til å lese litt bedre? Det er greit at vi skal endre praksis og ikke bare lage puggeprøver, men det burde vel fremdeles være gangbart å ha litt allmennkunnskaper?

2 kommentarer:

Du har inne på rapporten ser jeg - det interessante er - hvis du kjenner elevene godt - er om det er de som vanligvis gjør det bra, som gjør det bra her, eller om det virker nokså tilfeldig. Så kan du også - se på hvilke spørsmål som mange har bommet på, og forsøke å analysere dette.

Jeg har kjørt to flervalgstester, i den ene klassen var snittet fire (Vk2 - idrett) - i den andre var snittet 3/4. Jeg tror ikke på automatisert retting av åpne spørsmål i dette stoffet.

Jeg kjørte en modifisert utgave av en prøve som ble laget en kollega, jeg gjorde den litt vanskeligere. Når kollegaene melder om høyere snitt, lurer jeg på om det er fordi jeg ikke har terpet så mye på boka (og prøven var veldig "læreboknær"). 4 i idrettsklassen mener jeg forøvrig er et rimelig snitt å forvente, det samme med 3.

påbygg (3/4). Jeg lagde forøvrig kjapt en treningstest nå som de kan ta flere ganger i forbindelse med retorikk - veldig motiverende å teste seg sjølv med dra og slipp, osv.

Uansett - vi må her - gjøre som du gjør, reflektere over vår egen praksis, og ivareta elevene slik at de får de karakterene de "bør få"

Det gikk noe bedre i den andre klassen, men forskjellene er marginale. Jeg tror kanskje ikke at testen er så urimelig lenger, men heller at mange elever undervurderte den. De har vært vant til å få småtester på 10-15 spørsmål, og de har kunnet gjette seg til mange svar, gå frem og tilbake osv. Da jeg sa til dem at dett ikke var en øvingsoppgave, men en test av hva de faktisk hadde lært så det ut til at mange forsto dette. Kanskje de leser mer til neste gang?

Samtidig ser jeg at noen har fått feil fordi alternativene har vært for like osv. Mange skulle nok ha hatt noen få poeng til. Er det mulig å justere karakteren manuelt i ettertid?

Legg inn en kommentar

Jeg har flyttet, så kommentarer på denne bloggen blir ikke lenger fulgt opp. Du finner meg på http://ingunnkjolwiig.no